2017_Learning Efficient Object Detection Models with Knowledge Distillation_NIPS2017_chenguo bin

一、背景及意义(动机)

虽然基于卷积神经网络的检测方法在精度上得到了改进,但是速度上却无法满足实时。很多方法被提出来进行模型的加速,知识蒸馏就是其中的一种方法,但是之前知识蒸馏只是应用到分类任务。虽然知识蒸馏在分类任务上得到了比较好的结果,但是对于检测任务来说,具有新的不同的挑战。主要原因有以下几个:1)由于检出标签较少而导致性能的下降;2)针对分类的知识蒸馏方法,假设每个样本都是同等重要的,但是对于检测来说,前景更加重要;3)检测任务更加复杂,它组合了分类和回归任务。另外本论文只关注同个领域的知识迁移,没有使用到额外的数据和标签,这也会增加难度。为了处理上面的这些挑战,在这篇论文中,作者提出了一个新的知识蒸馏框架去学习一个压缩并且快速的检测网络,并在原有的框架上加入了一些新的trick,比如使用加权交叉熵loss来解决样本不平衡问题,使用teacher bounded loss来控制回归组件,使用自适应层利用teacher内部分布学习得更好。最后作者在PASCAL、KITTI、ILSVR和MS-COCO数据集上测试了提到的方法的有效性。在各个数据集上速度和准确率都得到了一致的提高。

二、使用什么方法来解决问题(创新点)

主要贡献

1.将分类任务中的知识蒸馏思想应用到检出任务,提出一个端到端的训练框架,利用知识蒸馏来压缩多分类的目标检测模型。

2.提出一个新的loss来有效解决将知识蒸馏技术应用到检出任务会存在的几个挑战。具体的,利用weighted cross entropy来解决样本不平衡问题;利用teacher bounder regression loss来进行知识蒸馏;将adaptation layers用于暗示学习(hint learning),通过它可以让student能够利用teacher内部神经元的分布学得更好。

3.在PASCAL、KITTI、ILSVR和MS-COCO数据集上测试了提到的方法的有效性。

4.洞察框架的表现行为,并与泛化和欠拟合问题相关联。

三、方法介绍

3.1 整体框架

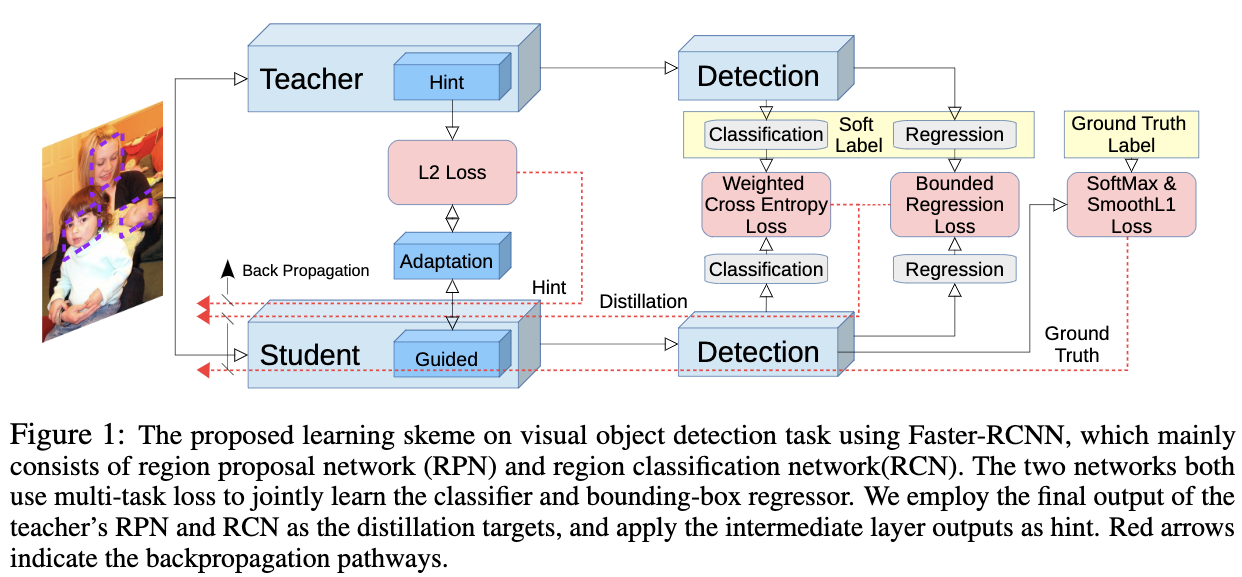

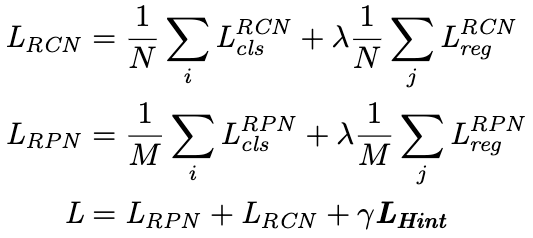

在该论文中,作者采用Faster-RCNN目标检测框架,该目标检测框架主要包括三个部分:1)共享的特征提取部分;2)RPN网络;3)RCN网络。本论文主要就是通过学习teacher网络中这三部分的知识来获取一个准确率和效率都高的student网络。Fig1给出了整体的学习框架。在该学习框架中,作者首先利用hint based learning,让student网络的特征与teacher网络的特征尽可能地相似;然后利用知识蒸馏的技术让teacher网络来指导student网络中RPN子网络和RCN子网络中的分类任务,为了解决在目标检测中严重的类别不平衡问题,作者在知识蒸馏框架中,使用了加权的交叉熵loss;最后,作者以upper bound的形式(也即如果student的回归输出比teacher要好,则没有额外的loss产生,只有student的回归输出比teacher差的时候才会产生回归loss)将teacher网络的回归输出传输到student网络。完整的目标函数可以表示为:

完整的loss由3部分组成,第一部分是RCN回归loss($L_{reg}^{RCN}$)和分类loss($L_{cls}^{RCN}$),第二部分是RPN的回归loss($L_{reg}^{RPN}$)和分类loss($L_{cls}^{RPN}$),第三部分是$L_{hint}$ loss。其中N为RCN的batch size;M为RPN的batch size。分类loss由两部分组成,原本的loss+知识蒸馏loss;回归loss由真实loss+teacher约束的l2回归loss组成;最后$L_{hint}$ loss,主要是为了鼓励student去模仿teacher的特征表示。这里两个超参$\lambda$,$\gamma$分别设置为1和0.5。

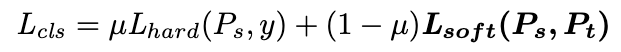

3.2 $L_{cls}$

$L_{cls}$可以表示为:

$L_{cls}$主要包括两个部分:1)student预测值跟真实值的loss 2)student预测值跟teacher预测值的loss。这两个loss都是softmax with loss,两者通过加权的方式相加,$\mu$为加权因子。由于在检测任务中,存在较大的样本不平衡问题,这里作者使用了一个加权的交叉熵loss作为distillation loss:

作者通过加权将背景的权重调大,在PASCAL数据集上作者把背景的权重赋为1.5;前景权重赋为1.0。在应用知识蒸馏技术的时候,当$P_t$的输出值很接近hard label的时候(输出的值靠近1和0),会使用一个temperature参数T去soften输出。在该论文中,作者发现temperature参数设置为1.0的时候得到的结果最好。

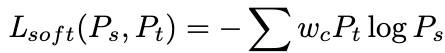

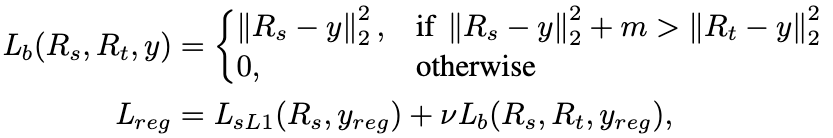

3.3 $L_{reg}$

对于回归任务来说,直接使用teacher的回归输出作为指导,可能会让结果变差。所以作者没有直接使用teacher回归输出作为目标,而是利用它作为上界让student去达到这个上界。student的回归向量应该尽可能的接近真实的目标,但是一旦student的质量超过了teacher并达到了一定的量,就不再给student提供额外的loss。作者把这种操作叫做teacher bounded regression loss($L_b$)。最终$L_{reg}$可定义为:

这里$m$表示预定义的一个间隔,$y_{reg}$表示回归的ground truth label,$R_s$则是student网络的回归输出,$R_t$则是tearcher网络的预测值。这里$L_{sL1}$是平滑L1loss。这里$L_b$主要是对于那些没有达到teacher回归精度的目标进行惩罚。

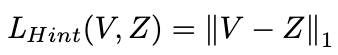

3.4 $L_{Hint}$

hint学习主要的目的是让teacher能够指导student的特征学习。所以在这里作者使用了L1loss来让student能够学习到teacher的特征表示。另外为了让特征维数一致,作者使用了Feature Adaptation层,这里的特征自适应层使用的是一个1X1的卷积层。用Z表示teacher网络中被选做hint的特征层,用V表示student网络中被指导的特征层。则$L_{Hint}$可表示为:

作者发现使用了特征自适应层能更好的指导student学习。尽管在student和teacher的特征维数一致的情况下,仍然能得到更好的结果。当隐含层和指导层的标准化不同时,自适应层也可以很好的匹配差异。当隐含层和指导层是卷积层并且两者的分辨率不同时,作者通过pad技巧来让他们具有相同的分辨率。

四、实验结果

数据集方面,作者使用KITTI、PASCAL VOC 2007、MS COCO、ILSVRC2014数据集进行实验。其中KITTI和PASCAL是小数据集,而MS COCO和ILSVRC2014为大的数据集。

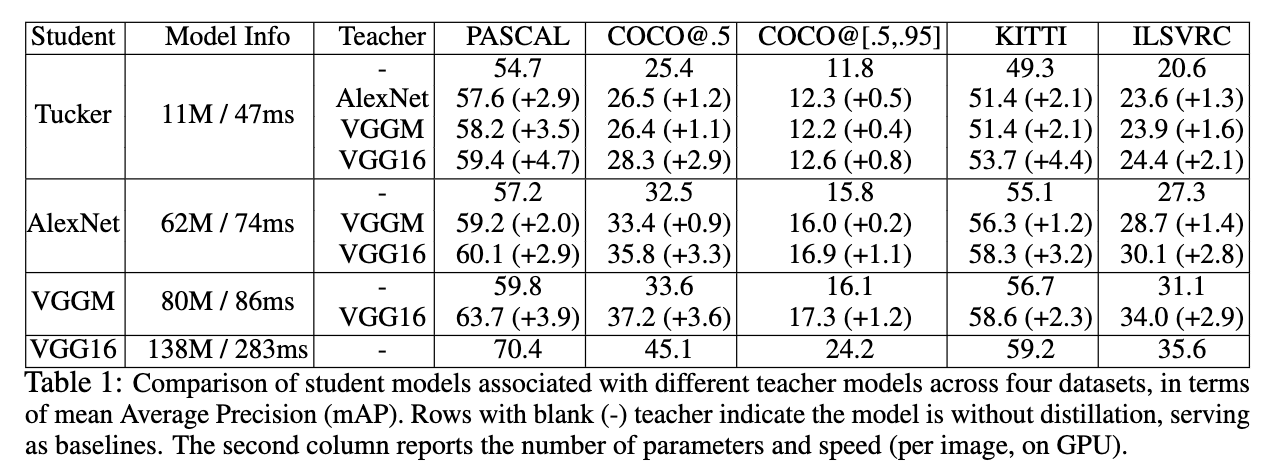

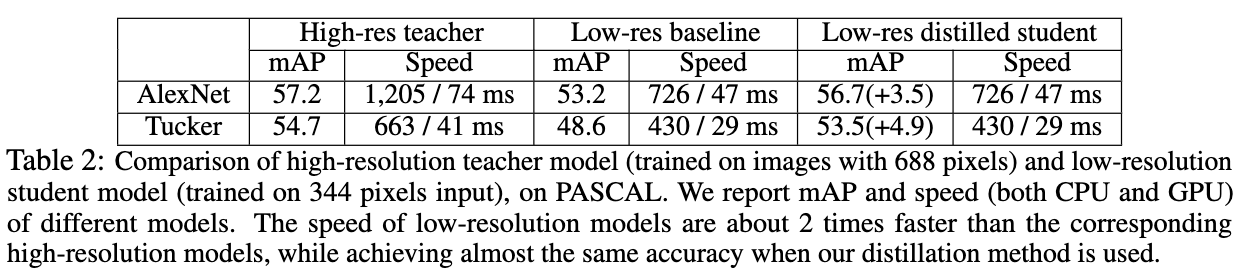

模型方面,作者选用了Alexnet,Alexnet with Tucker 分解,vgg16和vggm作为实验网络,并且采用两种不同的实验设置。第一种是使用小网络作为student,大网络作为teacher。另一种是使用image size小的作为student,input image size大的作为teacher,但是网络结构不变。

Table1给出了使用不同的teacher网络和不同的student网络在各个数据集上的表现。从Table1中可以看出,在使用知识蒸馏之后,相较于不使用知识蒸馏,模型的效果都得到了提升;另外在使用性能更好的teacher网络的情况下,模型提升的效果更多。

Table2给出了使用相同的网络但是不同输入分辨率作为teacher网络(高输入分辨率)和student网络(低输入分辨率)的结果。从Table2可以看出,在使用知识蒸馏技术之后,低输入分辨率的模型的效果基本与高输入模型的效果接近,但是输入提升了不少。

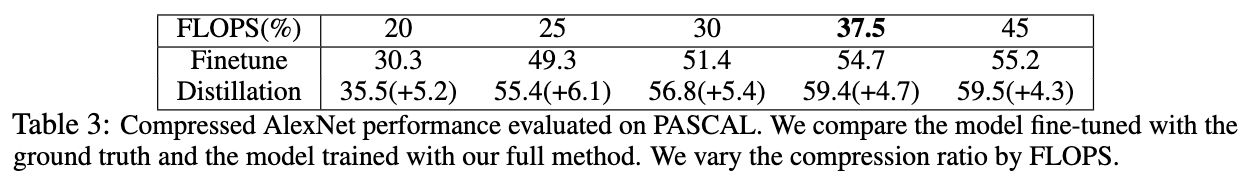

Table3给出了不同压缩率下的模型,直接使用ground truth label进行finetune与使用提到的知识蒸馏框架进行训练的效果对比。从Table3可以看出,使用提到的方法,效果要好很多。

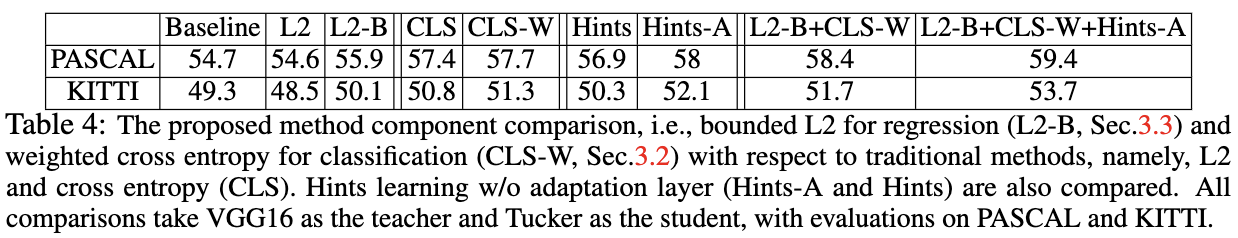

Table4给出了一些探究性的试验结果。所有的实验都以VGG16作为teacher网络,以Tucker作为student网络。

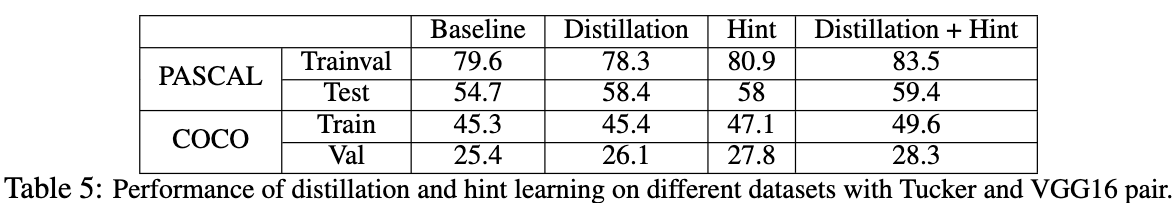

Table5给出了Distillation和Hint在训练集和测试集上的效果。从Table5可以看出,Distillation主要提高模型的泛化性,而Hint则提高了训练和测试的准确率。

转载请注明来源,欢迎对文章中的引用来源进行考证,欢迎指出任何有错误或不够清晰的表达。可以在下面评论区评论,也可以邮件至 524813168@qq.com

文章标题:2017_Learning Efficient Object Detection Models with Knowledge Distillation_NIPS2017_chenguo bin

文章字数:2.2k

本文作者:xieweihao

发布时间:2018-04-06, 21:43:59

最后更新:2020-04-06, 17:20:00

原始链接:http://weihaoxie.com/post/44b77463.html版权声明: "署名-非商用-相同方式共享 4.0" 转载请保留原文链接及作者。