2016_Identity Mappings in Deep Residual Networks_ECCV2016_HeK et al

一、背景及意义(动机)

在这篇论文中,作者通过分析残差构建块的前向和反向信号传播机制,发现当使用恒等映射作为skip connection,并在残差函数与shortcut相加之后也使用恒等映射的时候,前向和反向信号可以直接从某个构建块,传播到任意一个构建块。并根据这两个条件提出了一个新的残差模块,使网络更加容易训练,并且泛化能力更好。最后作者在CIFAR-10和CIFAR-100数据集上使用1001层的resnet,以及在Imagenet数据集上使用200层的resnet都取得了较好的结果。

代码https://github.com/KaimingHe/resnet-1k-layers

二、使用什么方法来解决问题(创新点)

2.1 对深度残差网络的分析

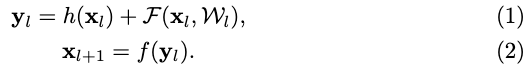

如上图所示为之前提出的残差块,其中$x_l$为第$l$层的输入特征,$x_{l+1}$为对应的输出;$W_l=\{W_{l,k}|_{1<=k<=K}\}$为该残差单元的权重和偏置;$K$为层数;$F$表示残差函数;$f$为逐点元素加操作之后的操作,比如在原先的残差单元是ReLU;$h(x_l)$为恒等映射,即$h(x_l)=x_l$。

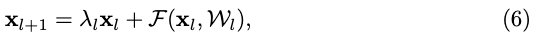

如果$f$也是恒等映射即$x_{l+1}=y_l$,那么等式(2)就可以表示为:

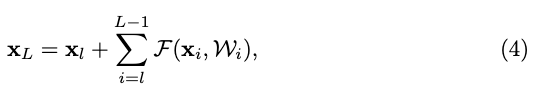

将$x_l$不断进行展开,则可以得到:

从等式(4)可以看出,对于任意深的模块$L$和对于任意浅的模块$l$,任意深的单元都可以表示为任意浅的单元加上一个残差函数,这就可以把任意两个单元之间的所有单元,看做是一个残差块。等式(4)也带来了非常棒的反向传播属性,根据链式法则,loss函数对任意一层的求导可以表示为:

从等式(5)可以看出,loss对任意一层的导数可以分解成两部分,一部分是信息直接传播到任一层不需要涉及到任何权重的,另一部分则是涉及到权重层。这种方式也使得传递到$l$层的梯度不会消失。等式(4)和等式(5)说明信号可以直接从任意单元直接传播到另一个单元。为达到这个目的需要满足两个条件1)$h(x_l)=x_l$ 2) $f(y_l)=y_l$

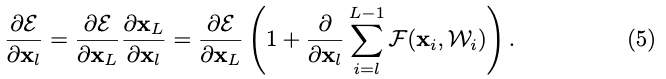

2.2 提出的新的残差模块

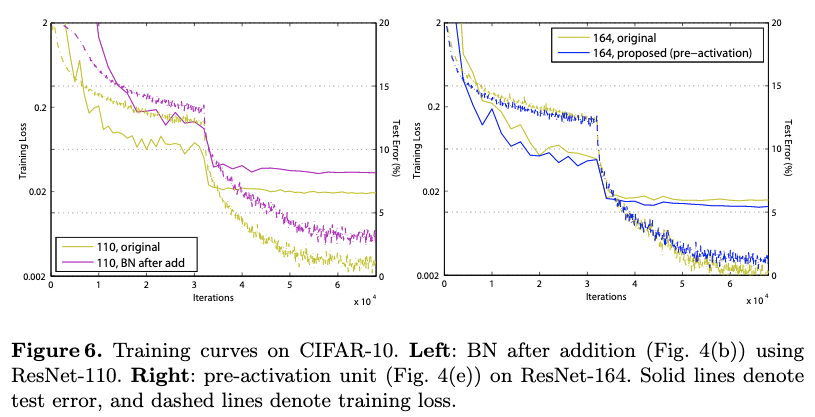

这里将卷积、BN和RELU的位置做了调换,使得该构建块满足提到的两个条件,即$h(x_l)$和$f(y_l)$都是恒等映射的。可以看到通过这种变换,模型拟合得更好,loss更低。

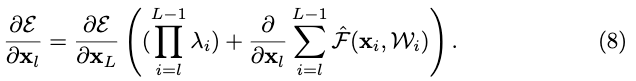

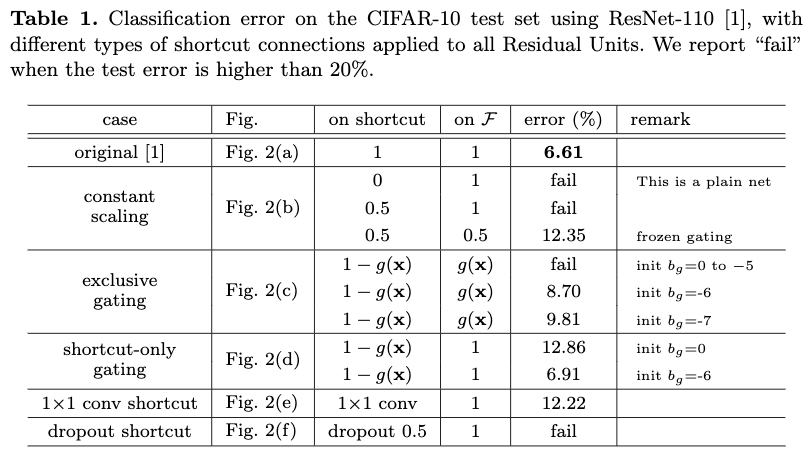

三、对提到的两个条件的重要性进行验证

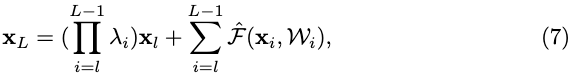

4.1 Identity skip connections的重要性。

作者做了简单的修改,通过设置$h(x_l)=\lambda_lx_l$打破了恒等shortcut,即为:

则前向传播展开后为:

对应的反向传播为:

从等式(8)可以看出当对于所有的$i$,$\lambda_i>1$时,很容易发生梯度爆炸;而当$\lambda_i<1$时则很容易发生梯度消失,这些都带来了优化困难。

上面的结果是同个结构跑5次,取平均。从结果来看,恒等映射是最好的。

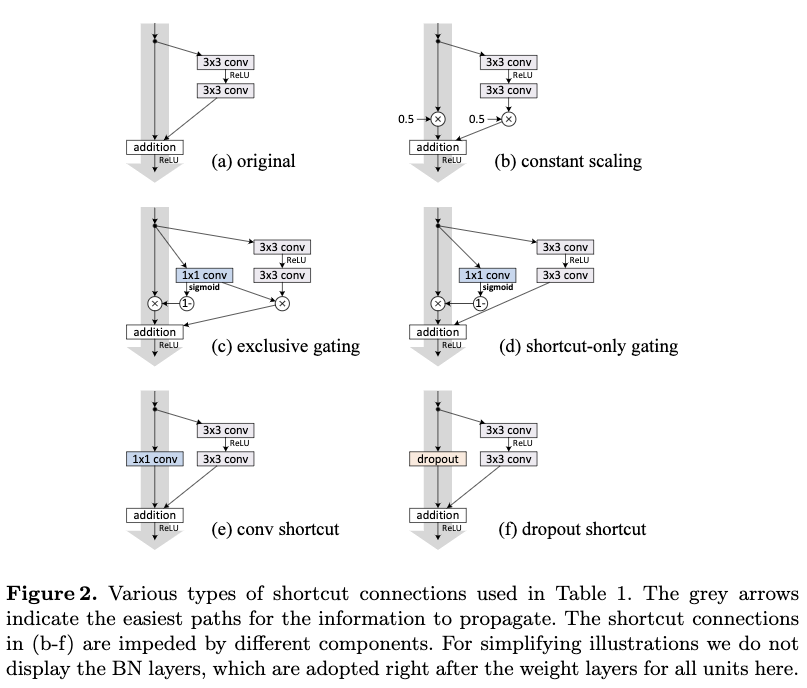

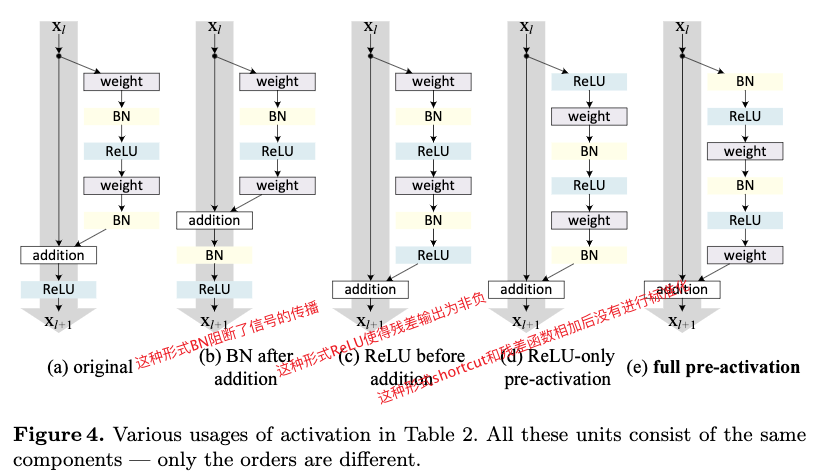

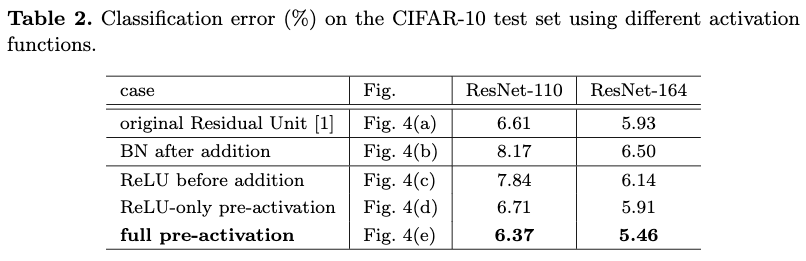

4.2 激活函数的使用

原本的残差单元$f=ReLU$并不是恒等映射,为了调查$f$为恒等映射时对结果的影响。作者调查了了以下形式的残差单元。

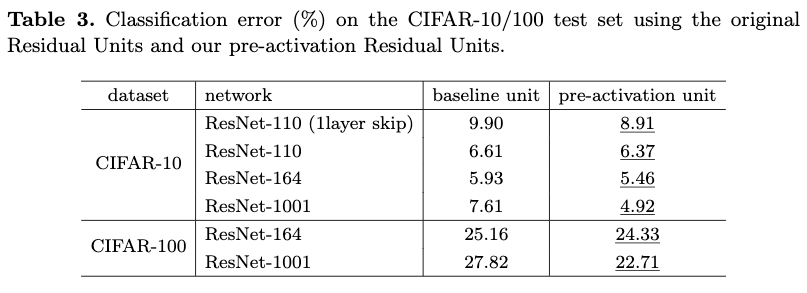

从Table2和Table3看出提出的构建块比其他形式更好。

4.3 结果分析

通过pre-activation的方式,带来了两个好处:

- 使得优化更加容易。

从图1可以看出利用提到的构建块构建的1001层的resnet loss降得很快,也达到了当前所有模型中能达到的最低loss。另外作者也发现当层数不多的时候,f=ReLU并不会对训练带来特别严重的影响,从Figure6(right)中可以看出,loss与提到的构建块差不多。 - 提高了泛化能力。

从Figure6(right)中可以看出,虽然在较少层的情况下,f=ReLU并没有带来很严重的影响。但是,从测试误差可以看到,本论文提到的构建块泛化能力更强。从Figure4(a)和Figure4(e)可以看出原本的构建块shortcut部分在与残差部分相加之后并没有进行标准化操作,而本论文提到的构建块两边都进行了标准化。

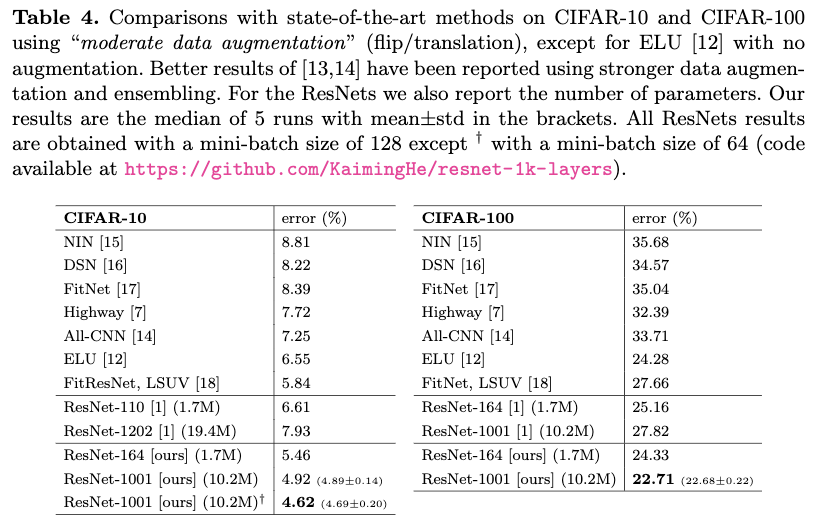

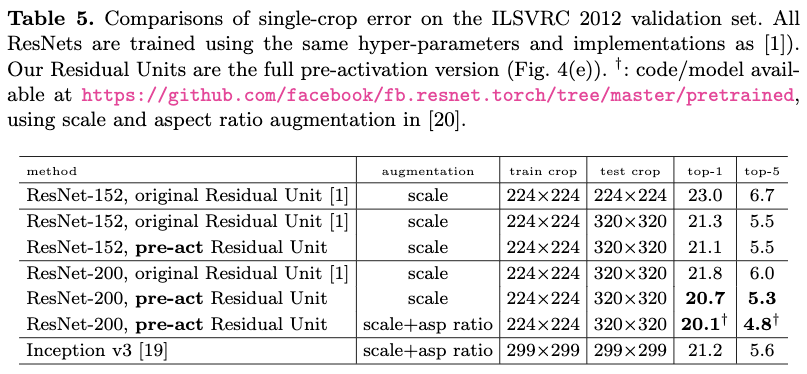

四、实验结果(与最新方法的比较)

从结果可以看出,提出的残差块具有很大的优势。详细的参数设置可以查看原文。

转载请注明来源,欢迎对文章中的引用来源进行考证,欢迎指出任何有错误或不够清晰的表达。可以在下面评论区评论,也可以邮件至 524813168@qq.com

文章标题:2016_Identity Mappings in Deep Residual Networks_ECCV2016_HeK et al

文章字数:1.2k

本文作者:xieweihao

发布时间:2017-01-14, 17:15:30

最后更新:2020-01-23, 10:20:55

原始链接:http://weihaoxie.com/post/96c98dd3.html版权声明: "署名-非商用-相同方式共享 4.0" 转载请保留原文链接及作者。